Attention-over-Attention Neural Networks for Reading Comprehension

[TOC]

任务

Close-Style Reading Comprehension(D-Q-A)

要解决的问题

An attention mechanism in LSTM(GRU):

Question Document 互相attention

提出的模型

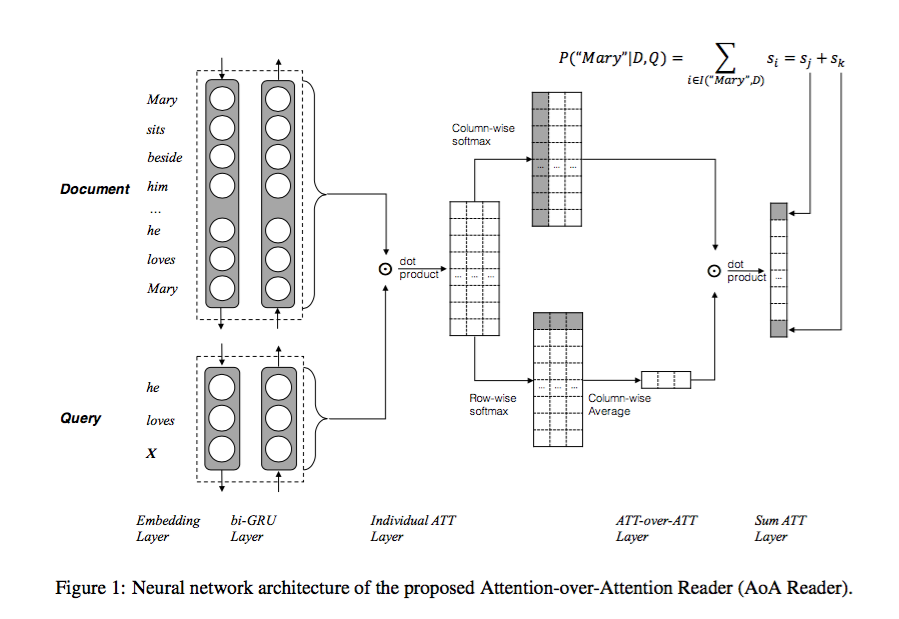

- Attention-over-Attention-LSTM:

实验部分

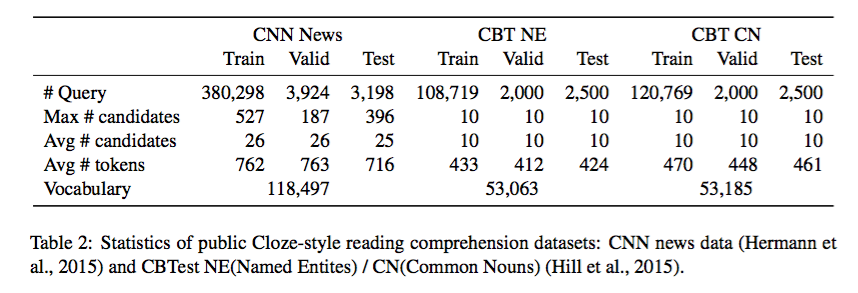

- 实验数据:

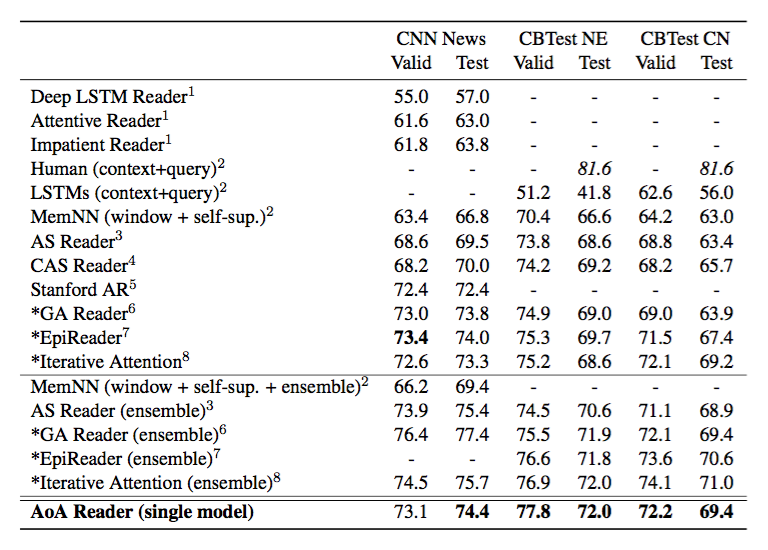

- 实验结果:

可借鉴的地方

- 1.实验的全面性

- 2.Question Document 互相attention

反馈与建议

- 微博:@伟康青年,@github

- 邮箱:wavejkd@pku.edu.cn